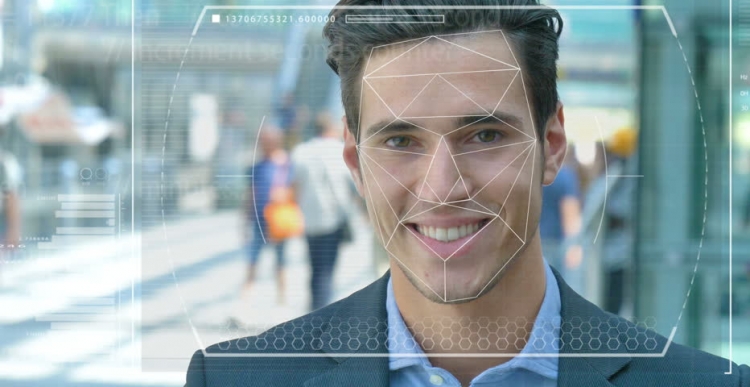

Полиция и силы безопасности во всем мире испытывают автоматизированные системы распознавания лиц для того, чтобы использовать их в качестве инструмента для идентификации преступников и террористов. Но насколько точна эта технология и насколько легко она и искусственный интеллект (ИИ), на основе которого она функционирует, становятся инструментами преследования и притеснения?

Возможности системы

Представьте, что подозреваемый террорист отправляется на самоубийственную миссию в густонаселенный центр города. Если он бросит бомбу, сотни людей могут погибнуть или получить тяжелые ранения. Процедура сканирования лиц в толпе с помощью видеонаблюдения позволяет выделить злоумышленника и автоматически сравнивает его характеристики с фотографиями в базе данных известных террористов или «лиц, представляющих интерес» для служб безопасности.

В случае обнаружения совпадений система поднимает тревогу, и антитеррористические силы быстрого реагирования отправляются на место, где они «обезвреживают» подозреваемого, прежде чем он сможет активизировать взрывчатку. Сотни жизней спасены благодаря современной технологии.

Возможные проблемы в работе

Но что, если технология распознавания лица (FR) сработала неправильно? И это оказался не террорист, а обычный человек, которому просто не повезло и он оказался похож на злоумышленника. Невинная жизнь была бы просто уничтожена, потому что специалисты слишком верили в ошибочную систему. А что если таким человеком окажетесь вы?

Это всего лишь одна из этических дилемм, поставленных перед системой распознавания лиц и искусственным интеллектом, лежащий в ее основе. Обучить машины «видеть», распознавать и различать предметы и лица действительно сложно. При помощи компьютерного зрения, как его иногда называют, не так давно исследователи попытались определить разницу между булочками с изюмом и чихуахуа, что стало своего рода лакмусовой бумажкой для определения эффективности этой технологии.

Трудности в распознавании лиц

Специалисты по компьютерным технологиям, Джой Буоламвини, представляющий лабораторию Массачусетского технологического института (и одновременно с этим основатель Лиги алгоритмического правосудия), и Тимнит Гебру, технический соруководитель команды Google по этическим вопросам, связанным с искусственным интеллектом, показали, что система распознавания лиц с большим трудом различает мужчин и женщин, если их кожа достаточно темного цвета. Система довольно часто принимала женщин с темной кожей за мужчин.

«Около 130 миллионов взрослых американцев уже находятся в базах данных по распознаванию лиц, - сказал доктор Гебру в мае на конференции AI for Good Summit в Женеве. - Но исходные наборы данных содержат в основном представителей белой расы, среди которых гораздо больше мужчин. Поэтому при распознавании лиц с более темным типом кожи до сих пор наблюдается огромный процент ошибок из-за типа кожи и пола.

Использование технологии

Калифорнийский город Сан-Франциско недавно запретил использование системы распознавания лиц транспортными и правоохранительными органами в знак признания его несовершенства и угроз гражданским свободам. Но другие города в США и других странах мира продолжают испытывать эту технологию.

В Великобритании, например, полицейские силы в Южном Уэльсе, Лондоне, Манчестере и Лестере тестируют эту технологию, что приводит в ужас такие организации гражданских свобод, как Liberty и Big Brother Watch, которые обеспокоены количеством ложных совпадений, возникающих при работе системы.

Ошибки и опасения

На практике это означает, что невинных людей ошибочно называют потенциальными преступниками. По словам доктора Гебру, такие проблемы, безусловно, должны вызывать беспокойство у каждого, использование подобные превентивных и предсказательных мер предполагает высокие ставки.

Учитывая, что темнокожие американцы составляют 37,5 % всех заключенных в тюрьмах США (по данным Федерального бюро тюрем), несмотря на то что они составляют всего 13 % населения США, плохо написанные алгоритмы, использующие представленные в настоящее время наборы данных, могут предсказать, что чернокожие люди с большей вероятностью совершить преступление. Не нужно быть гением, чтобы понять, какое это может иметь значение для полицейской и социальной политики.

Совсем недавно ученые из Университета Эссекса пришли к выводу, что совпадения, используемые в судебных процессах в столичной полиции Лондона были ошибочными в 80 % случаев, что потенциально может привести к серьезным нарушениям правосудия и ущемлению права граждан на неприкосновенность частной жизни.

Один британец, Эд Бриджес, начал судебное разбирательство по поводу использования технологии распознавания лиц полицией Южного Уэльса после того, как была сделана его фотография в то время, когда он шел за покупками, а комиссар по информации Великобритании Элизабет Денхем выразила обеспокоенность по поводу отсутствия правовых рамок, регулирующих использование технологии распознавания.

Но такие опасения не помешали техническому гиганту Amazon продать свой инструмент Rekognition FR полицейским силам в США, несмотря на нерешительный бунт акционеров, который все равно ни к чему не привел .

Перспективы

Amazon говорит, что не несет ответственности за то, как клиенты используют ее технологии. Но сравните это отношение с Salesforce, технологической компанией по управлению взаимоотношениями с клиентами, которая разработала собственный инструмент распознавания образов под названием Einstein Vision.

«Технология распознавания лиц может быть уместна в тюрьме для отслеживания заключенных или предотвращения насилия со стороны банд», - сказала Би-би-си Кэти Бакстер, специалист по этическим вопросам, связанным с искусственным интеллектом, компании Salesforce. Но когда полиция хотела использовать его вместе с камерами при аресте людей, в компании сочли это неуместным. При этом следует задаться вопросом, нужно ли вообще использовать ИИ в определенных сценариях, и одним из примеров этому является распознавание лиц.

В настоящее время эта технология используется и военными, поскольку поставщики технологий утверждают, что их программное обеспечение может не только выявлять потенциальных врагов, но и распознавать подозрительное поведение.